.avif)

.svg)

.svg)

.svg)

.svg)

.svg)

.png)

.png)

.png)

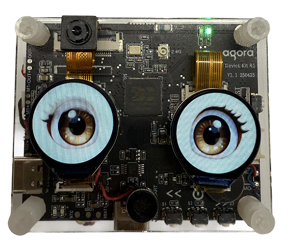

Agora permite conversaciones de voz más naturales con IA, gracias a las respuestas de baja latencia y la gestión de interrupciones en tiempo real. La supresión de ruido de fondo, la cancelación de eco y el bloqueo de atención selectiva integrados de Agora permiten que la IA escuche al usuario con claridad en cualquier entorno. La red global en tiempo real de Agora garantiza la conectividad y el rendimiento en cualquier lugar.

Puedes conectarte a cualquier LLM que sea compatible con OpenAI, incluidos los modelos GPT de OpenAI, Google Gemini, DeepSeek o cualquier modelo personalizado que sea compatible con OpenAI. Pronto habrá soporte para LLM adicionales.

Review our documentation on connecting LLMs here: https://docs.agora.io/en/conversational-ai/models/llm/overview

Para implementar un agente de IA de voz, necesitas conectar un LLM y un servicio de texto a voz al Conversational AI Engine de Agora. Esto permite una personalización completa con el LLM y la voz de tu elección.

Review our documentation on connecting ASR models here: https://docs.agora.io/en/conversational-ai/models/asr/overview

Agora’s Conversational AI Engine currently supports the following TTS providers:

Review our documentation on connecting TTS models here: https://docs.agora.io/en/conversational-ai/models/tts/overview

Agora’s Conversational AI Engine currently supports the following AI avatar providers:

Review our documentation on connecting avatar providers here: https://docs.agora.io/en/conversational-ai/models/avatar/overview

To implement a voice AI agent, you need to connect an LLM and a text-to-speech service to Agora’s Conversational AI Engine. This enables full customization of the experience, with the LLM and voice of your choice.

El 'modelo encadenado' describe cómo la voz se transforma en respuesta: primero, se convierte a texto; luego, el LLM procesa ese texto; y finalmente, el LLM genera una respuesta de voz.

No, el Conversational AI Engine de Agora requiere un modelo de IA o LLM existente. La plataforma permite la interacción de voz personalizada con el LLM, pero no es capaz de crear o entrenar un LLM.